AI似人,伦理与法律边界在哪:道教伦理

“人工智能(AI)医疗的发展实属新兴领域,无论是在‘现在时’还是‘将来时’的运用中均存在大量的未知空间道教伦理。”西南政法大学民商法学院商法教研室讲师刘梦祺曾在最新一期《中华医学杂志》发表的《人工智能医疗应用的现实难题及法律对策探析》中表示,在开展AI医疗的过程中,AI一方面能推动公共卫生和医学实践的巨大进步,为民众的医疗和保健提供更优质便利的服务;另一方面我们也逐渐认识到AI医疗的发展对人类会产生潜在的负面影响,患者的隐私保护、医疗损害赔偿的责任认定以及衍生的伦理性问题将日益凸显。

AI和人类产生分歧怎么办道教伦理?

AI在医疗应用中的伦理问题,既有AI应用的常规问题,也有与医疗相关的特殊伦理问题道教伦理。例如部分医疗行业从业者会担心AI和医生发生分歧怎么办?医生的自主权怎么保证?

在医疗护理方面,诊断中,AI在放射学和医学成像领域应用较为广泛,可仍相对新颖,尚未常规应用于临床决策道教伦理。目前,AI用于评估诊断肿瘤、眼科和肺部疾病,并可能通过成像、超声心动图等,实现卒中、肺炎、宫颈癌等疾病的及时检测;同时用于预测心血管疾病、糖尿病等疾病或重大健康事件的发生。临床护理中,AI能预测一些疾病进展和耐药性。

专家指出,在临床护理的某些方面,AI取代人类的判断是有好处的,例如与机器相比,人类可能做出更不公平、更有偏见、更糟糕的决定道教伦理。当机器能够更快速、准确、灵敏地执行决策时,将决策交给人类,可能意味着一些患者会发生可避免的病变和死亡。

目前,在医疗卫生领域,决策权尚未完全从人转移到机器道教伦理。矛盾的是,在AI和医生出现“同行分歧”的情况下,如果医生忽略机器,AI就没有什么价值;如果医生选择完全接受AI的决定,可能会削弱其权威和责任。

比“同行分歧”更甚的情况可能是AI系统正在取代人类成为认知权威,常规医疗职能可能会完全交给AI道教伦理。如果不采取适当措施,将削弱人类的自主权,人类可能既不明白AI是如何决定的,也不能与AI谈判,以达成协商的决定。

法律层面存在现实难题

“AI医疗的行为主体认定是当前理论界与实务界共同关注的首要问题,只有首先明确AI医疗的主体地位,后续的法律问题及相应的解决措施才能得到系统化的推进道教伦理。”刘梦祺指出,AI医疗主体的定位主要在医疗设备或器械与医生之间徘徊,换言之究竟定位是“物”还是“人”?如果认定是医疗设备,那本质上仍然是民事法律关系中的客体,与普通的工具别无二致。

展开全文

刘梦祺指出,AI医疗发展的趋势在于能够具有独立的意志(思考力和决策力),在脱离人类的控制下可以进行自主操作,单凭这一点我们就难以将其一直固定于“物”的范畴道教伦理。如果将其定位为医生,它的主体定位是与自然人医生完全相同,还是在法律上定义为具有完全或有限的人格?是否可以赋予AI医疗与医生相同的权利和义务?在确立了AI医疗主体定位的基础上,同理可推导其行为的性质。若将AI医疗定位为“物”,其行为只能视为是医生的医疗行为。相反,若将其主体定位为“人”,即AI医疗的行为主体是自己,其是否与自然人一样享有民事权利和具有民事行为能力?

除此之外,AI医疗中的医患关系也是关注焦点道教伦理。传统医患关系之间发生纠纷及其责任认定问题在我国现有的以《民法典》侵权编为代表的法律规定中已经得到了较为完善的解决。然而当AI在医疗活动中为人类带来高效、智能的医疗服务时,不可避免地会发生AI医疗诊断错误、治疗过程出现故障等情况,从而引起新型的医疗纠纷,使他人人身或财产受到损害。

当前阶段,AI医疗在临床应用中发挥了一定的诊疗功能,可基本上扮演辅助医生的角色,最终诊疗决策还是依靠医生来确定道教伦理。因此,当AI医疗使人受到损害可以根据《民法典》的规定视情况而定。若是AI医疗设备本身存在缺陷,应由生产者或医疗机构承担无过错责任;若是医生过错、过失导致患者受到损害,应当由医生(医疗机构)承担赔偿责任。

尝试多种解决办法

AI医疗现存问题众多,因此法律、医疗等领域的从业者均提出了多种解决办法道教伦理。

刘梦祺认为,第一,应否认AI医疗的法律主体地位道教伦理。一方面是源于其无法依靠算法设计完全替代医生在诊疗活动中发挥的作用。另一方面,人类应当明确并达成共识——无论在现在还是将来,医疗领域只能以人类为主导,因为其关乎每个人的生命健康。若在立法上赋予AI医疗法律地位以及相应的行为能力,有朝一日人类的健康和安全将会受到巨大的威胁。

第二,应优化AI医疗各利益方的责任制度体系道教伦理。在使用层面细化医疗机构和医生的责任,在制造层面明确生产商的责任。

第三,应建立专门的AI医疗监督委员会道教伦理。“安全原则是AI应用的核心,包括物理意义上的技术安全和抽象意义上的安全可控。”刘梦祺表示,将AI引入医疗领域对于人类来说,最重要的还是确保其安全性。在各方利益冲突的情况下,专设AI医疗监督委员会具有重大意义。

重庆医科大学附属第三医院心血管内科主治医师王端指出,政府部门和AI行业要尽快制定严格的医疗AI技术标准、安全标准和应用规范,构建动态的评估评价机制,以便对医疗AI的基础平台、技术研发、产品与服务、临床应用、安全与伦理等方面加以指导和监管道教伦理。在大数据背景下,要兼顾医疗数据共享与患者隐私安全。除在技术上对数据采取“匿名化”、加密存储等措施外,加强数据管理也是重中之重。

此外,各国政府和世界行业组织等也纷纷发布伦理原则,鼓励科研人员将伦理问题置于AI设计和研发的优先位置,强调AI应当符合人类价值观,服务于人类社会道教伦理。

例如,2016年12月,美国电气和电子工程师协会发布了《合伦理设计:利用人工智能和自主系统(AI/AS)最大化人类福祉的愿景》;2017年1月,来自全球近千名AI领域专家在 Beneficial AI 会议上联合签署了《阿西洛马人工智能原则》道教伦理。

从国家层面来看,2018年以来,英国、欧盟相继发布了《人工智能准则》和《人工智能道德准则》,我国于2019年6月发布了《新一代人工智能治理原则——发展负责任的人工智能》,提出“和谐友好、公平公正、包容共享、尊重隐私、安全可控、共担责任、开放协作、敏捷治理”八条原则道教伦理。

2021年,世界卫生组织(WHO)与20人专家领导小组合作,确定了AI医疗6项核心原则,以提高AI在医疗卫生领域使用的伦理水平道教伦理。这6项核心原则为:保护自治权,促进人类福祉、人类安全和公共利益,确保透明度、可解释性和可理解性,培养责任感和问责制,确保包容和公平,促进具有响应性和可持续性的AI发展。

“医学技术的本质是解除患者痛苦,AI医疗的发展目标也应如此道教伦理。如果仅仅追求技术的不断突破而丧失了对人类安危的守护,那么这既违背了医者的初衷,也偏离了人类发展的正确路线。”刘梦祺说道。

原文载于《医学科学报》 (20220902 第5版 封面)

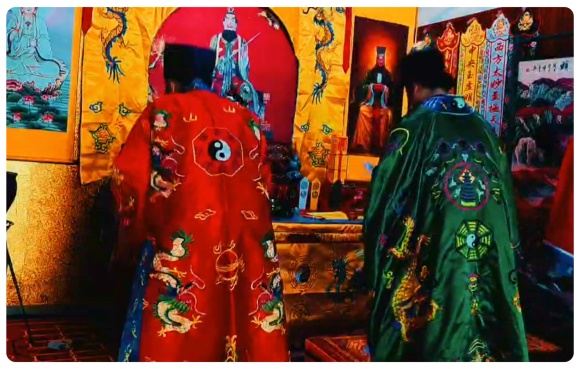

法事类型如下:

01.化解太岁法事; 02.升官晋职法事 ;03.文昌考试法事; 04.偿还阴债法事; 05.开财门补财库; 06.助种生基法事; 07.催子受孕法事;08.开运转运法事;09.催财发财法事;10.化解童子法事;11.化解小人法事;12.小儿平安法事; 13.超度亡灵法事; 14.超度宠物法事; 15.超度婴灵法事;16.祈福许愿法事;

师父微信: master8299

师父微信: master8299

符咒类型如下:

01.财运符; 02.太岁符; 03. 回心符; 04. 护身符;05. 学业符;06. 开运符; 07. 桃花符; 08. 偏财符; 09 .小人符;10 .事业符;11. 去疾符; 12. 健康符;13. 平安符;14 .和合符;15.定制符;

师父微信: master8299